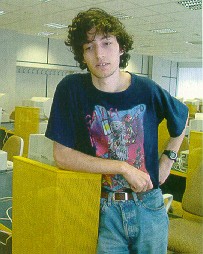

A SZTAKI szuperszámítógépe: 28 duál Pentiumos PC és egy hasonló felépítésű szerver, Cisco kapcsolóval összekötve |

Az igazán tekintélyes számítástechnikai teljesítményeket a szuperszámítógépekhez kapcsoljuk. Néhány éve még e kifejezés hallatán titokzatos monstrumok jelentek meg a képzeletben. Azóta a számítógépek elvesztették misztikumukat. Most a szuperszámítógépek is demokratizálódnak. E téren az utóbbi idők számítástechnikai fejlődésének, valamint a fölhalmozott szakmai tőkének köszönhetően Magyarország is képes érdemi eredmények elérésére. Mi a szuperszámítógép? Mire lehet használni, hogyan változik ez napjainkban? Minderről Kacsuk Péter, az MTA Számítástechnikai és Automatizálási Kutató Intézete (Sztaki) Párhuzamos és Elosztott Rendszerek Laboratóriumának vezetője adott információkat lapunk olvasói számára.

Több szuperszámítógép is épült az utóbbi időkben Magyarországon. Az ELTE gépében szabvány PC-s alaplapokat építettek tömbbé egy közös házban. A SZTAKIban megvalósított rendszer kinézetre olyan, mint egy tanterem, a különálló PC-k kapcsolóval nagy sávszélességű helyi hálózatban működnek együtt úgy, hogy az eredmény egy szuperszámítógép. Mindkét megoldás azt jelenti, hogy néhány tíz millió forintos költséggel szinte már magánszemély is megvalósíthatna ilyet. Emellett a szupergépek teljesítménye egyre tágabb kör számára elérhető. Mindez a különösen nagy teljesítmények alkalmazásában új felvirágzást jelent, akár a tudomány, akár a gazdaság, az ipar lehetőségeit tekintjük. Nemcsak hogy ma is vannak kiemelkedő teljesítményt igénylő feladatok, hanem ezek fajtáinak száma is, a megoldás lehetővé válása miatt az igény is világszerte viharosan növekszik. Érdemes tehát megismerkedni mindezekkel, kiváltképp, mert a hazai eredmények által immár a magyarországi használat is elérhető.

Hogyan lehet megragadni azt a fogalmat, hogy szuperszámítógép? Régebben ehhez a kiemelkedő teljesítményt társítottuk; jelent-e azonban valami sajátosat architektúra, funkciók szempontjából is?

K. P.: Ma is a megszokott számítástechnikai teljesítményeknél sokkal nagyobbak értendők szupergép-teljesítményen, a beugró mondjuk 50-100 PC. Architekturálisan a legnagyobb különbség, hogy sok processzor van összeépítve a szuperszámítógépben. Egy PC-ben ma tipikus az 1-2-4 processzor, a szuperszámítógépekben általában 32-től több ezerig terjed a processzorok száma.

A processzoron teljes számítástechnikai egységet, vagy közönségesen lapkát kell értenünk?

K. P.: Mindkettő előfordulhat, a felépítéstől függően. A közös memóriás architektúrák esetén egy kapcsolóhálózaton át a memóriapoolt maguk a processzorok érik el. Ez nagyon előnyös a szoftveres szervezés szempontjából, nem kell azzal foglalkozni, hogy mit melyik memóriapartícióba teszünk. A másik szervezési módban viszont minden processzorhoz hozzárendelünk memóriát, ekkor egész számítási egységek működnek együtt egy hálózatban. Ennek felel meg a PC-s architektúra is. Ezek azért váltak az egyedi szuperszámítógépek versenytársaivá, mert megjelentek az ezt lehetővé tévő nagy sebességű kapcsolók. Ezekkel csaknem olyan sávszélesség érhető el az egyes PC-k között, mint amilyet korábban a szuperszámítógépen belüli speciális kommunikációs hálózat tett lehetővé a processzorok közt.

Milyen sávszélességet jelent ez?

K. P.: Ez attól függ, hogy hány adatút van kiépítve. A mi klaszterünkben 29 darab 100 megabit/másodperces kommunikációs csatorna működhet egyidejűleg, ami 2,9 gigabit/másodperc körüli sávszélességet eredményez.

Ha jól értem, egyetlen processzorral nem lehet elérni akkora teljesítményt, ami már szuperszámítógépet jelentene, tehát ahogy régen, ma is a fürtözés a megoldás. Eszerint az egyik kulcselem mindenképpen a hálózat; hogyan lehet ezt jellemezni?

K. P.: Rengeteg lehetőség van a hálózat kialakítására. A két fő irányzatot a statikus és a dinamikus megoldás jelenti. Statikus az a hálózat, amelyben rögzítetten össze vannak kapcsolva a processzor-memória párok egymással valamilyen szabályos topológia szerint, például négyzetrácsba, fa-szerkezetbe, hiperkockába. Ez azt jelenti, hogy ha két távoli processzornak kell megtalálnia egymást, valami módon meg kell keresni az ehhez tartozó adatutat. Ennek a megoldásnak sokáig az volt a hátránya, hogy a gépek alkotta rácspontokon való adatrelézés, az "ugrálás" időszükséglete nagy és nem egyforma. A 90-es évek elején olyan technológiák születtek, például a wormhole (féregút) routing, amelyek gyakorlatilag kiküszöbölik a problémát. Ugyanakkor e megoldás előnye, hogy viszonylag egyszerű a hálózat felépítése, és nagymértékben bővíthető a rendszer a szélein a szabályosság szerint. Általában ezt a hálózati kialakítást alkalmazzák az elosztott memóriás szuperszámítógépekben. Dinamikus kapcsolóhálózat például a crossbar-, azután a multistage, amelyben egymással kommunikáló kommunikációs csomópontok alkotnak rétegeket stb. Az effajta megoldás általában gyorsabb, viszont sokkal drágább, különösen a bővíthetőség szempontjából. A közös memóriás szuperszámítógépekben ez az elterjedt változat, és a sebességnek épp az az ára, hogy az ilyen rendszerek kevésbé bővíthetők.

Milyen az átvitel egy ilyen hálózatban?

K. P.: Ezekben annyi kommunikációs útvonal alakulhat ki, ahány processzor egyidejűleg elérhet memóriamodulokat. Az "effektív" sávszélesség tehát dinamikusan alkalmazkodik.

A SZTAKI szuperszámítógépe: 28 duál Pentiumos PC és egy hasonló felépítésű szerver, Cisco kapcsolóval összekötve |

K. P.: Másképp kell szervezni a működést a közös memóriás felépítésekben,

mint az elosztott memóriásokban. Az első esetben az operációs rendszernek

azt kell biztosítania, hogy bármelyik processz bármelyik processzoron végrehajtható

legyen, s eközben a memóriát bármelyik processz elérhesse.

E felépítésben az operációs rendszereknek nagyon fontos a szerepük,

ami előnyös; a felhasználó elől el van takarva sok, az ő számára tulajdonképpen

mellékes részlet. A rendszer nagyobb mértékben tűnik egyetlen entitásnak,

mint az elosztott memóriás. Kisebb a felhasználó felelőssége, kevesebb

a feladata, a rendszer garantálja, hogy az arra alkalmas feladatok párhuzamosan

hajtódnak végre. A második fajta felépítés esetén ezzel szemben az adatok

megszervezésén, a feladatok processzekre bontásán túl sokszor az is a felhasználó

feladata, hogy eldöntse, az egyes részfeladatokat melyik processzorhoz

és memóriához rendeli, tehát figyelnie kell még az adatstruktúrák megfelelő

particionálására és kiosztására is. Ha mindezt ügyetlenül csinálja, rossz

esetben lassúbb lesz a programja, mint egy PC-n. Jó esetben viszont n darab

processzorral közel n-szeres sebességnövekedést ér el, ami a szuperszámítógép

ideális kihasználásának felel meg.

Visszahat-e a szuperszámítógépes feladatmegoldási mód kifejlődése az egyedi gépeken működő programokra? Olyasmire gondolok, ahogy a kezdeti hardveres neurális hálózatokat szoftveres úton sikeresen szimulálva bizonyos feladatok esetében új és eredményes megközelítések születtek.

K. P.: Vegyük először az operációs rendszert. Ha teljes PC-k kommunikálnak, egyedi operációs rendszerekkel, akkor szükség van egy fölső szintű kommunikációs szoftverrétegre, amely a szétosztást is vezényli. Ma már szabványosnak tekinthető két ilyen megoldás: a Parallel Virtual Machine, azaz PVM; illetve a Message Passing Interface, vagyis MPI. Az elsőt egy amerikai egyetem fejlesztette, a másodikat egy ipari cégekből és kutató intézményekből álló konzorcium, a PVM tapasztalatai alapján. A cél az volt, hogy a párhuzamos számítógépes programok hordozhatók legyenek. A nyolcvanas évek végére ugyanis kiderült, hogy a legnagyobb probléma a hordozhatóság. Ami futott mondjuk egy Crayen, azt nem lehetett átvinni egy Sunra. Holott egy-egy ilyen csomagban iszonyú mennyiségű szellemi munka volt, a hardverplatform-változások viszont különféle okokból egyre gyorsultak. A feladatok szupergépekre való programozását mint piacot ez nagyon gátolta, az érdekelt cégeknek tehát meg kellett egyezniük, félretéve minden rivalizálást. Az MPI kommunikációs felületet ma minden komoly szuperszámítógép-gyártó implementálja, optimalizálja a platformjára.

Mondhatjuk tehát, hogy a szuperszámítógépnek van már definíciója, amelyet éppen mondjuk az MPI fogalmaz meg?

K. P.: Ez így van. Az alkalmazó számára ma már mindegy, milyen a hardverplatform; a fontos a szoftverinterfész, amelyen keresztül a hardvert használja. Az egyik fajta tehát a PVM vagy az MPI. A másik pedig az úgynevezett Virtual Shared Memory, a VSM. E koncepció szerint a használat szempontjából egyszerűbb, tehát hatékonyabb közös memóriás rendszert valósítják meg fizikailag elosztott memóriás hardveren.

K. P.: Jól ismert problémakör az időjárás-elemzés. Véges idő alatt le kell futtatni a prognózist, és nem mindegy, hogy milyen pontossággal. A meteorológusok között tipikus az a szemlélet, amely szerint ha elegendően nagy számítógép áll rendelkezésre, a kívánt pontosság és megbízhatóség elérhető.

Persze, ehhez kell az a hit, hogy az időjárás olyan determinisztikus rendszer, amely jósolható, és nem lép fel benne például káosz.

K. P.: Ha valahol végleg nem adható előrejelzés, az is csak úgy derülhet

ki, ha elmennek a felbontásban az elérhető határig. Ehhez valóban szuperszámítógép-teljesítmény

szükséges. Mindenesetre a szuperszámítógépek iránti szükséglet indoklása

nem áll rosszul. Létezik egy szuperszámítógépes csúcslista, amelyet félévente

újítanak meg (http://www.top500.org). Ez nemcsak felsorolja az élvonal

gépeit, hanem statisztikákat is megad az alkalmazást illetően. 1993 óta

folyamatosan nő az ipari alkalmazások száma.

Épp idén értünk el oda, hogy az ipari felhasználások aránya túllépte

az 50 százalékot. A maradék oszlik meg a kutatásban, a gyártók saját célú

felhasználásában, a kormányzati alkalmazásokban. Ez egyben azt is jelenti,

hogy az ipar egyre többet fektet be az ilyen gépek használatába, fejlesztésébe

is.

Milyen további területeken alkalmazzák azeket?

K. P.: Szintén közismert az autóipar igénye. Gyorsan, magas igénnyel kell fejleszteni az autókat, és a kísérletek helyébe a szimulációk léptek, nemcsak mert olcsóbbak, hanem mert a gyorsaság üzleti kulcsszempont. Ma már ütközéseket is megbízhatóan szimulálnak.

K. P.: Valóban így van. Ami az alkalmazásokat illeti, a régen ismert

tudományos témák ma is futnak, nemrég írtak ki Amerikában nagy tendert

az atomfegyver-kísérletek szimulációval való helyettesítésére. Ez kezdettől

szupergépes terület. Azután a biológia, a génfeltérképezés, az agymodellezés;

a vegyészet, az új anyagok számítógépes megtervezése; a Föld modellezése,

az óceánmodellezés; csillagászati-kozmológiai számítások, feketelyuk-modellezés

- számtalan terület van, ahol bizonyos problémák számítógépes kezelése

a realitások tartományába tolódott a tudományos vágyálmokéból. Ez önmagában

is izgalmas volna.

Azért soroltam föl ezeket, mert a problémák kalíbere akkora, hogy megoldásukra

egyetlen szuperszámítógép nem elég, sok szuperszámítógép összekapcsolását

igénylik. Ez a szuperszámítógépekkel foglalkozó informatika homlokterébe

került: hogyan lehet a sok távoli szupergépet úgy összekapcsolni, hogy

azok egyetlen nagy szuper-szuperszámítógépként működjenek?

Nem beszélhetnék össze néhány barátommal, hogy az interneten át a gépeinkből valósítsunk meg szupergépet?

K. P.: A sávszélességtől eltekintve igen. Ilyen projekt van is, pontosabban nagyon nagy számítási kapacitást igénylő feladatokhoz ad-hoc gépegyüttest lehet létrehozni az interneten megvalósuló technológiára alapozva. A CETI projekt is ilyen, ez a világűrből érkező rádiójelhalmaz elemzése avégből, hogy az esetleges intelligens tartalmat a zajból ki lehessen szűrni. Viszonylag független adatelemzésekről van szó, bárki letölthet magának egy adatcsomagot, fölajánlva a gépét a programhoz, letöltődik egy képernyővédős program, és miközben a képernyővédő fut, a háttérben végbemegy a számítás.

Az ilyesfajta lehetőségek a szupergéptől a PC-kig afelé mutatnak, hogy a számítástechnika még olcsóbb lesz, hiszen a gépek kihasználtsága növekedhet. Hogy állnak a szupergépeket összekötő megoldások? A SZTAKI nyilván mélyen érdekelt ezekben. Milyen a SZTAKI rendszere?

K. P.: Konkrétan: 28 darab, Linuxot futtató duál-pentiumos PC-ből áll a rendszerünk, ehhez járul egy duálpentiumos vezérlő szervergép. Egy Cisco kapcsolóval 100 megabit/másodperces Ethernet hálózatba vannak kötve. A felépítés azt teszi lehetővé, hogy a fürt különböző PC-i páronként egyidejűleg tudjanak egymással kommunikálni. Ez a klaszter szinte minden vonatkozásban kielégíti a szuperszámítógép definícióját. Az egyes gépeken futó linuxok felett ott a PVM vagy az MPI, és efölött van az a rendszer, amelyet a SZTAKI kifejlesztett: ez egy fejlesztőrendszer, arra, hogy bárki alkothasson erre a klaszterre olyan programokat, amelyek látják a processzorokat. Ilyen programot írni nem olyan könnyű; bár elvileg az MPI lehetővé teszi, de nem ad támogatást a hibakereséshez, a teljesítményelemzéshez stb. A mi rendszerünk ezeket pótolja. A neve: Professional Grade (P-Grade).

Mi volt a céljuk a támogatórendszer kifejlesztésével?

K. P.: Az általa nyújtott teljes grafikus környezetben olyan alkalmazók is megjelenhetnek, akik nem "mélyinformatikusok", hanem például meglévő Fortran-programjukat szeretnék párhuzamosítani kényelmes körülmények között.

A régi időkben ha valaki számítástechnikával oldott meg problémát, mindjárt a számítástechnikának is tudósává kellett válnia. A magas szintű automatikus eszközök ezt fölöslegessé tették, és ezzel megnyitották az utat a tág körű használathoz. Most valami hasonló megy végbe a szuper-számítástechnikában is?

K. P.: Igen, megszületnek az univerzális felületek, terítékre került a nyitottság, a hordozhatóság. A felhasználó elől eltakarják a számára fölösleges részleteket, a technológiát. Legalábbis látszik ez az út.

Hol tartanak rajta?

K. P.: Egyelőre még nem valósult meg a használatnak ez a demokratizmusa. Egy egyszerű C programot jelenleg nem nagyon tudunk közvetlenül párhuzamosítani, hiányoznak a céleszközök. A mai ambíciónk az, hogy a programozót minden lehetséges eszközzel támogassuk az ilyen nehéz feladatok elfogadható megoldásában. Azaz kialakulnak a fejlesztőeszközök szupergépekre.

|

Szalai Ferenc negyedéves ELTE fizikus hallgató, a SZTAKI munkacsoportjának aktív tagja. Az ELTE Biológiai Fizika Tanszékkel közösen szemcsés anyagok, valamint polimerek vizsgálatával foglalkozik, a Komplex Rendszerek Fizikája Tanszék számára kozmológiai modellek futtatásában vesz részt a szuperszámítógépen, valamint a European Grid Forum testbed-programjában dolgozik. |

K. P.: Az Országos Meteorológiai Szolgálattal van egy közös IKTA-projektünk. Ebben a Szolgálat NowCast nevű programcsomagját támogatjuk. Ahogy a neve is mutatja, ennek célja a pillanatnyi időjárási állapot kiszámítása az ország különböző pontjain. Ezt kell aztán összevetni a ténylegesen mérhető értékekkel. Nem közömbös, hogy milyen sűrűségű a háló, amelyben az adatmegfigyelési pontokat elhelyezhetik, és hogy az adott eredményekből milyen gyorsan lehet a percek múlva előálló értékeket előre kiszámítani. Az általunk fejlesztett eszközzel a NowCastot fogják párhuzamosítani. Jelenleg 10 km-es horizontális felbontással állítják elő a meteorológiai változók analizált értékeit, és ez körülbelül 30 percet vesz igénybe, ami messzemenőleg nem elégíti ki az előrejelzők elvárásait, akik a mérések után már néhány perccel szeretnék a komplex analízis eredményeit felhasználni. Ennek az elvárásnak csak lehet megfelelni, ha az analízis rendszer végrehajtási sebességét ugrásszerűen fokozzák, s ennek egyik hatékony módja a program párhuzamosítása.

Ebből milyen haszna van a SZTAKI csapatának?

K. P.: Számunkra ez referencia és próbapálya a saját fejlesztőeszközünk fejlesztéséhez. Ugyanakkor a projekten belül szeretnénk továbbfejleszteni a P-Grade rendszert. Egy fürtbe bármikor beléphetnek az interneten keresztül újabb felhasználók, ami különböző terheléseket jelent, tehát a load balancing, a terheléskiegyensúlyozás válik problémává, hogy hogyan lehet a terhelés függvényében átirányítani a gépek között processzeket stb.

Milyen további konkrét feladatokon dolgoznak?

K. P.: Van egy tavasszal elfogadott NI2000-es projektünk, amelyben a Globus és a Condor metacomputing vagy más néven gridcomputing rendszereket vizsgáljuk, teszteljük, értékeljük, hogy a hazai kutatói közösség számára használható szolgáltatásokat fejlesszünk ki. Nemrég adtunk be továbbá egy projektet az Oktatási Minisztériumba, amelyben az ELTE több tanszéke, a győri Széchenyi István Főiskola, az MTA SZTAKI, az MTA KFKI RMKI és az MTA MFA kutatóintézetek vesznek részt. Nagyon sokféle programot fog ez össze, vannak agykutatók, magfizikusok, csillagászati problémán dolgozók, a győri főiskola a Rábával működik együtt motortervezésen.

Mindez egyetlen projekten belül!?

K. P.: Ezek úgynevezett testbed-problémák, amelyeken azt próbáljuk ki, hogy a projekt során kidolgozandó technológia mennyire alkalmazható különféle problémákra. E technológia kidolgozása és tesztelése a fő cél. A program neve: Demogrid.

Miért grid?

K. P.: Azért, mert a munka végső soron arra irányul, hogy különböző számítógépeket, erőforrásokat, szuperszámítógépeket kapcsolhassunk össze nagy sebességű hálózaton keresztül egyetlen nagy méretű és nagy kapacitású rendszerré. Az ilyen rendszerek kutatása az Egyesült Államokból indult ki, és onnan származik a grid elnevezés. Az USA-ban a gridkutatások prioritása rendkívül nagy, és az utóbbi időben Európában is erre fordult a figyelem. Megalakult például a European Grid Forum a kutatások előmozdítására. Ennek több bennünket is érintő munkacsoportja van, magam vagyok a vezetője a teljesítményelemzési munkacsoportnak, amely a jövőben szorosan együtt fog működni az amerikai Grid Forum hasonló területen dolgozó munkacsoportjával. Performance Analysis Work Package-nek nevezik, együttműködünk ennek egy amerikai megfelelőjével is. Hadd említsem itt a CERN által vezetett rendkívül nagy (több mint 20 résztvevős, költségterve 30 millió euró) európai Data Grid Projektet, amely 2001 januártól fog indulni, és amelyben a kutatócsoportunk is részt vesz, épp a már említett klaszterre támaszkodva. A CERN 2006-ra építi föl az új gyorsítóját. Azt jósolják, hogy évente petabájt méretű adatmennyiségek állnak majd elő. Ma a terabájt tartományban vannak, a három nagyságrenddel nagyobb adatmennyiség feldolgozására egyetlen intézet nem lesz képes. Húsbavágóan fontossá válik számukra a távoli szuperszámítógépek és -központok közötti együttműködés lehetősége. A magyar Demogrid ennek a projektnek lesz a hazai megfelelője. Van ezen kívül egy APART nevű európai konzorcium, neve az Automatic Performance Analysis: Resource and Tools rövidítése. Ezt sikeres munkája nyomán az Európai Bizottság fölkérte a folytatásra, és az újabb pályázatban a konzorcium engem kért fel a grid alapú teljesítményelemzési munkacsoport létrehozására.

Lehetséges, hogy a magyar kapacitás további működési lehetőségekhez jut?

K. P.: Előkészületben van több más európai projekt is. Az European Grid Forum egy testbedet akar bemutatni a novemberben az Egyesült Államokban, Dallasban tartandó szuperszámítógépes világkonferencián. Az európaiak demonstrálni akarják, hogy az európai szakmai közösség számítóközpontjai képesek valamely nagy volumenű feladat elosztott, közös megoldására, méghozzá adaptív módon, ahol a feladat automatikusan azokra a központokra terhelődik, ahol épp a legnagyobb szabad kapacitás áll rendelkezésre. Ebben részt vesz a SZTAKI, a paderborni, a poznani és a brnói Szuperszámítógép Központ, a berlini ZIB és a potsdami Albert Einstein kutatóközpont, valamint az amszterdami Freier Egyetem is. A heterogenitás miatt rengeteg a megoldandó probléma, a nyelvi különbségektől a technológiai platformokéig. A kulcsszó tehát a heterogenitás. Egy szuperszámítógép belül homogén, a miénk is. A grid esetében azonban ez nem tartható. Úgy kell általánosítani a szuperszámítógép-koncepciót, hogy az az esetlegesség, hogy a részei homogén sokaságot alkotnak, csak mint speciális eset szerepeljen benne.

Mennyire számít a hazai ipar a Sztaki hatalmas új kapacitására?

K. P.: Meg kell mondjam, e szempontból csalódott vagyok. Mintha azokhoz, akik érdemben igényelhetnék ezt a komoly számítási kapacitást, nem jutott volna el az információ a létrejöveteléről. Csak halvány érdeklődés mutatkozott. Az Országos Meteorológiai Szolgálattal is régebbi kapcsolatban álltunk, ez nyitotta meg az utat a mostani együttműködéshez. Nemrég zajlott le a "magyar szuperszámítógép" tender versenytárgyalása, e gépet a hazai kutatói közösség használatára szánja a NIIF Iroda. Szerintem azonban nem lesz elég, ha megvesszük a győztes Sun-rendszert, amely egyébként egy Enterprise HPC 10000-es konfiguráció, és a teljesítménye igen komoly, 60 gigaflopos lesz, amivel a top 500 mezőny közepére kerülünk fel. Reklámhadjáratra is szükség van, hogy a potenciális felhasználók megismerhessék a lehetőségeit. Ha ez nem történik meg, úgy járhat, mint a mi klaszterünk, készen áll a fogadásra, de nem jönnek a felhasználók.

Ez a helyzet speciális üzleti magatartást kíván. Önöket illetőleg: van erre irányuló marketingje a SZTAKI-nak?

K. P.: Megvallom őszintén, én kutató vagyok, nem marketingszakember.

Nekem nem az a feladatom. Mi túlléptünk a kötelességünkön, azon, hogy elkészítettük

a rendszert: nagy számú riportot, újságcikket segítettünk a napvilágra.

A weben is ott van az anyagunk (http://www.lpds.sztaki.hu).

Magam is sok társasággal tárgyaltam. Megszerveztem egy nagy és sikeres

nemzetközi szuperszámítógépes konferenciát Balatonfüreden szeptember 10-13.

között, a világ legrangosabb kutatóinak aktív részvételével. Aligha tehetek

többet.

Van-e valamilyen szervezet, amelynek ez a marketing lenne a feladata?

K. P.: Sajnos, nincs. A magyar kutatás piacosítására, eladására irányuló tevékenység ezen a területen nem működik.

Tihanyi László